Gianluca Valensise, del Dipartimento Terremoti, INGV, Roma, è sismologo di formazione geologica.Dirigente di ricerca dell’INGV, è autore di numerosi studi sulle faglie attive in Italia e in altri paesi. In particolare è il “fondatore” della banca dati delle sorgenti sismogenetiche italiane (DISS, Database of Individual Seismogenic Sources: http://diss.rm.ingv.it/diss/). Ha dedicato oltre 30 anni della sua carriera a esplorare i rapporti tra tettonica attiva e sismicità storica, con l’obiettivo di fondere le osservazioni geologiche con l’evidenza disponibile sui grandi terremoti del passato.

Da qualche anno è emerso, nel panorama geo-sismologico italiano, il termine “gravimoti”: gli abbiamo chiesto di commentare l’origine e il significato.

Da qualche anno abbiamo cominciato a sentire parlare di “gravimoti”, in alcuni casi come alternativa al termine “terremoti”. Ci puoi riassumere da dove nasce questa idea e a cosa si riferisce?

Si tratta di un concetto totalmente nuovo per la Sismologia e abbastanza complesso. La parola “gravimoti” è stata coniata da Doglioni e coautori in un articolo pubblicato sull’autorevole rivista Scientific Reports nel 2015. In genere si ritiene che i terremoti siano generati dal rilascio di energia elastica accumulata nel corso di secoli o millenni. Secondo questi autori, invece, nelle aree del globo sottoposte a estensione crostale, come ad esempio nel nostro Appennino, la maggior fonte di energia disponibile è rappresentata dalla forza di gravità. Ne consegue che le faglie estensionali, che in geologia si chiamano anche faglie normali, sono caratterizzate da un meccanismo di accumulo e dissipazione di energia diverso rispetto a quello di altri contesti geodinamici, come quelli compressivi e trascorrenti, nei quali l’energia elastica consente il movimento dei blocchi posti ai due lati di una faglia anche contro la forza di gravità.

Doglioni e coautori ritengono quindi che i terremoti per faglia normale seguano un meccanismo completamente diverso dal modello ideale dello elastic rebound, o rimbalzo elastico, teorizzato da Harry Fielding Reid nel 1910 sulla base di osservazioni della faglia che aveva generato il grande terremoto di San Francisco del 1906. E poiché ritengono che i terremoti per faglia normale siano dominati dalla gravità, questi autori propongono di definirli graviquakes – traducibile appunto con “gravimoti” in italiano – mentre tutti gli altri terremoti sarebbero degli elastoquakes, termine traducibile in “elastomoti”.

Come è stato recepito questo paradigma dagli altri ricercatori? E come se ne può dimostrare la validità oltre ogni ragionevole dubbio?

A essere onesti, a oggi i graviquakes non hanno ricevuto un’accoglienza entusiastica da parte della comunità scientifica, nonostante che nel frattempo i loro fondamenti teorici siano stati ripresi da Petricca et al. nel 2015. Le critiche principali vengono dagli esperti di meccanica delle rocce, che ritengono non derogabile il meccanismo noto come doppia-coppia che è alla base del calcolo dei meccanismi focali di tutti i terremoti.

Esiste in effetti un modo relativamente semplice per verificare l’ipotesi dei graviquakes. Un normale terremoto causato dall’accumulo e dal successivo improvviso rilascio di energia elastica causa il sollevamento di alcune porzioni della regione interessata dalla fagliazione e lo sprofondamento di altre. Poiché nel processo di generazione di un terremoto non c’è aggiunta o rimozione di volumi rocciosi, e poiché le rocce che formano la litosfera hanno una compressibilità limitata, il volume delle rocce di cui il terremoto – o meglio il movimento della faglia sismogenetica – ha causato lo sprofondamento deve necessariamente essere molto simile al volume delle rocce che ne sono state sollevate. Secondo gli autori citati questo non è però vero per i graviquakes, i quali, essendo dominati dalla forza di gravità, determinano uno sprofondamento di entità molto superiore al sollevamento, causando nel contempo l’espulsione di fluidi profondi ospitati in fratture preesistenti.

In un articolo pubblicato nel 2019 [1], sempre su Scientific Reports, Bignami e coautori hanno analizzato se questa ipotesi sia stata verificata dalla sequenza di Amatrice, Norcia e Visso del 2016, culminata con la scossa di magnitudo 6.5 del 30 ottobre 2016: una serie di terremoti che hanno causato deformazioni molto importanti della superficie topografica – nella Piana di Castelluccio è stato misurato uno sprofondamento massimo dell’ordine di circa un metro – e che sono state registrate da una moltitudine di strumenti e sensori di diversa natura (si veda in proposito la Figura 5 dell’articolo in questione):

per la spiegazione si veda qui:

https://www.nature.com/articles/s41598-019-40958-z/figures/5.

In particolare Bignami e coautori hanno analizzato i dati di interferometria differenziale – DInSAR nella letteratura in lingua inglese – forniti dalla costellazione di satelliti europei Sentinel. Questi consentono di misurare con precisione la forma della superficie del pianeta e le sue eventuali variazioni tra passaggi successivi del satellite sulla stessa zona, cosa che alle nostre latitudini avviene con una frequenza media di una volta ogni 3-5 giorni. Le variazioni misurate, opportunamente processate, consentono di rappresentare con straordinaria precisione e con grande risoluzione spaziale gli effetti in superficie del movimento della faglia sismogenetica, incluse le eventuali deformazioni pre- e post-sismiche, ma anche di studiare la dinamica di vulcani attivi, l’evoluzione di grandi corpi franosi, e persino le deformazioni del suolo causate dall’estrazione o immissione di fluidi profondi.

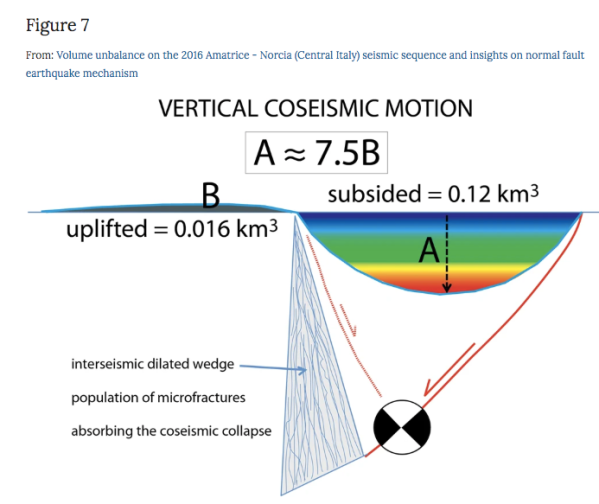

Ebbene, secondo i calcoli di Bignami e coautori il movimento delle faglie che hanno generato i tre terremoti principali (24 agosto, 26 ottobre e 30 ottobre 2016) ha causato lo sprofondamento di un volume di circa 0,120 km3, mentre la somma delle porzioni crostali sollevate non supera i 0,016 km3 (si veda la Figure 7 dell’articolo):

https://www.nature.com/articles/s41598-019-40958-z/figures/7.

Gli autori concludono che il terremoto ha causato un volume unbalance di circa 7,5 volte, in accordo con quanto previsto dalla teoria dei graviquakes. Come ha scritto Carlo Doglioni in un blog divulgativo della Sapienza [2], questo risultato “… getta nuova luce e conferme sul ruolo della forza di gravità nei terremoti…”; lo stesso Doglioni ha poi aggiunto che “…Prossimo obiettivo è la caccia ai volumi crostali in cui lungo l’Appennino vi siano zone dilatate, pronte a generare un futuro evento sismico”. Da quest’ultima affermazione consegue che, se l’esistenza dei graviquakes fosse confermata, i sismologi disporrebbero di un nuovo metodo per prevedere i terremoti a breve e medio termine, ancorché solo nelle aree sottoposte a tettonica estensionale (a riguardo ricordo che i terremoti estensionali sono largamente dominanti nel contesto geodinamico italiano). Una applicazione sistematica di questo metodo potrebbe consentire, se non proprio di prevedere i terremoti, quantomeno di identificare “zone di attenzione” prioritarie.

Dunque i manuali di geofisica e di sismologia sono da riscrivere?

Come ho già detto, la comunità scientifica nazionale è rimasta abbastanza fredda sui graviquakes, ma finora non ha espresso le proprie perplessità con pubblicazioni su riviste peer-reviewed, le uniche adatta ad ospitare un eventuale contraddittorio. Però la scienza è globale, e a maggior ragione lo sono i meccanismi che presiedono alla generazione dei terremoti. E così, a sorpresa, due ricercatori di oltre-Atlantico hanno recentemente deciso di impugnare le conclusioni di Bignami et al. e confutare la tesi di fondo dei graviquakes. Si tratta di Segall e Heimisson, dell’Università di Stanford in Californa, che in un breve ma concettoso articolo apparso sul Bulletin of the Seismological Society of America, una storica rivista considerata molto autorevole dai sismologi, discutono a tutto campo le conclusioni degli autori dell’articolo in questione.

Come prima cosa richiamano uno storico lavoro di Ward del 1986, nel quale si argomenta sul fatto che i volumi crostali mobilitati da un forte terremoto non devono necessariamente azzerarsi tra sollevamento e subsidenza: o meglio, prima o poi lo faranno, ma nell’immediato del verificarsi del terremoto è normale che si riscontri un certo disequilibrio – a favore della subsidenza nei regimi estensionali e a favore del sollevamento in quelli compressivi – proprio in virtù del fatto che la porzione più profonda della crosta terrestre ha un comportamento essenzialmente viscoelastico. In altre parole, la reologia delle rocce che formano la crosta terrestre è tale da rendere accettabile un modesto e transitorio volume unbalance.

Ma la critica principale ai risultati di Bignami e coautori riguarda il metodo utilizzato da questi ricercatori per i loro calcoli. Va premesso che secondo la teoria della elastic dislocation, comunemente accettata per descrivere il campo di deformazione generato da un forte terremoto, nel caso di una faglia normale la subsidenza si presenta concentrata in una depressione allungata come la faglia sismogenetica e poco più lunga della faglia stessa: un’area lunga intorno ai 20 km nel caso del terremoto del 30 ottobre 2016, nella quale, come ho già ricordato, sono stati registrati sprofondamenti fino a un metro circa. Viceversa, l’evidenza sperimentale rappresentata dall’andamento dei dati satellitari mostra che il sollevamento interessa una zona molto più grande, che nel caso in questione arriva fino alla costa adriatica, con valori assoluti che si riducono progressivamente da un massimo di 15 cm circa fino a zero (si veda sempre quanto mostrato nella Figure 5 di Bignami e coautori).

Segall e Heimisson fanno intanto notare che i calcoli sono stati effettuati in modo improprio: in particolare, sono state omesse tutte le aree dove il sollevamento misurato con la tecnica DInSAR dà un valore compreso tra +3 cm e -3 cm. Si tratta di una scelta obbligata, perché il sensore del satellite Sentinel è “cieco” per differenze di valore inferiore a 3 cm, ma che per le ragioni che ho ricordato poco sopra porta a sottovalutare drasticamente il volume della porzione del campo di dislocazione in cui i dati satellitari mostrano un sollevamento. Fanno poi notare che se i volumi fossero stati calcolati correttamente, cioè tenendo conto anche di quella zona molto ampia in cui il sollevamento registrato non è risolvibile con la tecnica usata, il volume unbalance dovrebbe ridursi ad un 20% circa; e concludono che, stando così le cose, i dati DInSAR del terremoto del 30 ottobre resterebbero pienamente compatibili con quanto previsto dalla classica elastic dislocation theory e con quanto asserito da Ward nel 1986.

Segall e Heimisson concludono la loro analisi con una frase che deve far riflettere sull’uso dei dati scientifici per promuovere o confutare una nuova teoria scientifica:

“We do not claim that the elastic dislocation model is unique. Occam’s razor, however, suggests that a simpler, well-tested theory (elastic dislocation theory) should be preferred.”

Credo che questa chiosa interpreti bene l’accoglienza abbastanza fredda fino ad oggi riservata ai graviquakes dalla comunità sismologica, prima nazionale e ora anche internazionale. Per parte mia posso solo osservare che applicando la metodologia di analisi proposta da Bignami e coautori al caso di faglie inverse, come quelle che hanno generato i terremoti del 20 e 29 maggio 2012 nella Bassa modenese – peraltro analizzati proprio da Bignami e coautori nel 2012 – probabilmente si otterrebbe lo stesso risultato, ma a parti invertite: si misurerebbe principalmente del sollevamento, e la subsidenza apparrebbe del tutto subordinata. Un risultato di questo tipo mostrerebbe senza necessità di ulteriori prove che il volume unbalance di quasi un ordine di grandezza invocato da Bignami e coautori è un artefatto del metodo di calcolo utilizzato, non una proprietà intrinsca del nostro pianeta, e renderebbe inveitabile riconsiderare i fondamenti della teoria dei graviquakes.

La parola torna ora a coloro che hanno inizialmente proposto l’esistenza dei graviquakes, nella speranza che accettino il suggerimento di usare i terremoti del 2012 per capire se quello che stanno vedendo e ipotizzando per la zona di Norcia – e per tutte le faglie normali in giro per il pianeta – è una reale e importante novità scientifica, o se si tratta solo di un artefatto modellistico.

[1] https://www.nature.com/articles/s41598-019-40958-z

[2] https://www.uniroma1.it/it/notizia/terremoti-del-centro-italia-dove-e-il-volume-fantasma

Nota: una risposta di Carlo Doglioni alle considerazione di Gianluca Valensise è stata pubblicata qui

Gravimoti: alcuni commenti all‘intervista di Valensise (Carlo Doglioni)

Bibliografia citata

Bignami C., P. Burrato, V. Cannelli, M. Chini, E. Falcucci, A. Ferretti, S. Gori, C. Kyriakopoulos, D. Melini, M. Moro, F. Novali, M. Saroli, S. Stramondo, G. Valensise e P. Vannoli (2012). Coseismic deformation pattern of the Emilia 2012 seismic sequence imaged by Radarsat-1 interferometry, Annals of Geophysics, 55, 789-795, ISSN: 1593-5213, doi: 10.4401/ag-6157.

Bignami C., E. Valerio, E. Carminati, C. Doglioni, P. Tizzani, e R. Lanari (2019). Volume unbalance on the 2016 Amatrice-Norcia (Central Italy) seismic sequence and insights on normal fault earthquake mechanism, Sci. Rep. 9, no. 1, 4250.

Doglioni C., E. Carminati, P. Petricca, e F. Riguzzi (2015). Normal fault earthquakes or graviquakes. Sci Rep 2015;5:12110. https://doi.org/10.1038/srep12110, 2015.

Petricca P., S. Barba, E. Carminati, C. Doglioni, e F. Riguzzi F. (2015). Graviquakes in Italy. Tectonophysics, 656(12):202–2014. https://doi.org/10.1016/j.tecto.2015.07. 001.

Segall P., e H. R. Heimisson (2019). On the Integrated Surface Uplift for Dip-Slip Faults. Bulletin of the Seismological Society of America, Vol. XX, No. XX, pp. –, – 2019, doi: 10.1785/0120190220

Reid H. F. (1910). The mechanics of the earthquake, The California earthquake of April 18, 1906. Report of the State Investigation Commission (Carnegie Institution of Washington, Washington, D.C., 1910).

Ward S. N. (1986). A note on the surface volume change of shallow earthquakes, Geophys. J. Int. 85, no. 2, 461–466.

Entro di nuovo nella discussione per commentare alcune affermazioni di Patrizio Petricca, sulle quali mi sento in dovere di fare delle precisazioni; che riguardano di fatto non la Sismologia ma il metodo scientifico.

So che sembra strano dover discutere di argomenti basilari che nella ricerca scientifica dovrebbero essere dati per scontati. Sembra però che negli ultimi anni il proliferare delle riviste scientifiche, e la stessa ossessione per le pubblicazioni come valore ‘metrico’ (vedi H-index), e non per il valore intrinseco di ciò che affermano, abbia portato spesso a dimenticare i concetti di base; che quindi vorrei qui ribadire.

Innanzitutto, non era mia intenzione, nel commento al post di Gianluca Valensise, scomodare Popper. Popper è nato nel 1902; le basi del metodo scientifico risalgono a molto prima (Occam è del 1300, Bacone del 1200; Galileo, pietra miliare del metodo scientifico, del 1600). La Scienza va avanti così, da sempre. E dunque voglio spiegare meglio, visto che non sembra essere stato ben compreso, il senso del mio commento.

La teoria della dislocazione elastica è una elaborazione fisico-matematica assolutamente universale, validata da tutte le osservazioni di qualunque tipo su qualsiasi materiale (anche quelli recenti di sintesi, polimeri, ecc.) che, entro certi limiti, abbia un comportamento molto vicino a quello di un solido elastico ‘ideale’. Poi, la teoria della dislocazione elastica viene applicata ‘anche’ per spiegare l’origine dei terremoti; ed anche qui non c’è mai stata alcuna ‘forte discrepanza’ che non possa essere motivata dalla non piena corrispondenza tra i materiali rocciosi dell’interno della Terra e i mezzi elastici ‘ideali’; colpisce semmai, come dicevo, l’incredibile corrispondenza con quanto realmente osservato anche in mezzi estremamente complessi.

Il senso del mio commento, necessariamente dai toni sfumati per il dovere di presupporre che certi concetti di base siano ben noti a tutti coloro che si occupano di ricerca, voleva puntualizzare appunto che non si può confutare una teoria ‘universale’, applicabile in innumerevoli ambiti, sulla base di ipotetiche piccole ‘deviazioni’, la cui significatività è tutta da dimostrare (e finora assolutamente indimostrata), che esisterebbero in un ambito estremamente ristretto (i terremoti di faglia normale). D’altra parte, il mio commento nell’ultima frase aggiungeva un’altra cosa che evidentemente non è stata compresa. Ossia che, a parte il ‘volume unbalance’ che, come si è detto, non è realmente misurabile con la precisione affermata, ma anche se lo fosse sarebbe ‘dimostrabilmente’ in accordo con i modelli di dislocazione elastica, non c’è alcuna osservazione fondamentale che il modello ‘graviquakes’ riesca a spiegare e la teoria della dislocazione elastica no. D’altra parte, quando si afferma appunto (qualitativamente peraltro) che il modello ‘graviquakes’ produrrebbe dati sismologici equivalenti a quelli previsti dalla teoria della dislocazione elastica (sorvolo sul fatto che secondo me non è vero, nel senso che il modello ‘graviquakes’ non spiegherebbe molte osservazioni fondamentali), si sta esattamente dicendo che non ci sono implicazioni sostanzialmente differenti e tali da giustificare l’abbandono di una teoria universalmente validata ‘anche’ per i terremoti di faglia normale. E quindi, quali sarebbero i motivi per abbandonare un modello ancorato ad una teoria ‘universalmente riconosciuta’ in favore di qualcosa di diverso, valido solo in un ambito molto locale, che produrrebbe gli stessi osservabili?

Stavolta cito veramente Popper, e dico che un modello non ‘falsificabile’ non ha molto senso. E lo posso dire anche molto più semplicemente, come probabilmente lo spiegavano i filosofi del ‘200: affermare che la pioggia non è prodotta dalla condensazione del vapore acqueo che ricade dalle nuvole, ma il risultato del pianto di tanti angioletti invisibili e giammai rilevabili in alcun modo, non ha evidentemente senso. Questo discorso, ovviamente, non va assolutamente confuso con altri: tipo ‘previsione dei terremoti’, ‘ciclo sismico’, ‘determinazione della pericolosità sismica’. Questi problemi, che nel post di Petricca sembrerebbero l’argomento principale di confutazione della teoria della dislocazione elastica (e difatti quasi tutta la letteratura portata ad esempio verte su tali questioni), sono di tutt’altra natura. Rappresentano infatti il nostro limite nella conoscenza e nella trattazione di fenomeni estremamente complessi come l’accumulo e la dissipazione di sforzi tettonici; oppure, nel caso delle stime di pericolosità, rappresentano scelte ‘convenzionali’ (ossia dettate dall’utilità e dagli scopi) per difenderci dai danni dei terremoti. Ma questi, che sono ‘modelli’ (empirici) nel senso stretto della definizione, non hanno nulla a che fare con la validità o meno della teoria della dislocazione elastica, che deriva invece dallo sviluppo di equazioni che descrivono il comportamento fondamentale dei solidi; né tantomeno possono metterla in discussione.

Che poi anch’io abbia letto su alcuni quotidiani (ed ascoltato personalmente in alcuni seminari, non senza essermi alzato per puntualizzare il mio dissenso scientifico), dopo alcuni forti terremoti recenti, che i massimi danni avverrebbero nella zona di abbassamento prodotta dalle faglie normali per effetti ‘gravitativi’, non voglio neanche commentarlo; da Sismologo (e da persona che si occupa di Scienza) preferisco dimenticarlo.

Spero stavolta di essermi espresso in maniera meno ‘sfumata’, in modo comprensibile a tutti.

Gentile Giuseppe De Natale, non vedo in quale modo sia messo in dubbio il metodo scientifico che, ovviamente, si evolve nella sua filosofia come ogni pensiero umano. Al contrario, nel mio commento precedente la critica è stata opposta e in favore di un metodo che per il momento, sull’argomento dell’articolo, viene solo evocato. Le riviste scientifiche rappresentano il mezzo con il quale le ricerche (in modo quantitativo) vengono diffuse, validate o falsificate. Se questo non avviene si rimane nell’ambito dei pareri.

La dislocazione elastica è un’elaborazione matematica universale (mi sembra ovvio, nessuno ha mai detto il contrario) come lo è (ovvia) l’azione della forza di gravità. Nessuno cerca di confutarla; mi sembra un falso argomento. O un contro-argomento (altrettanto falso) dovrebbe essere che l’applicazione della teoria elastica al ciclo sismico sulla base di piccole deviazioni confuta la gravitazione universale? Non ha senso. Inoltre, l’applicazione di un modello non è giustificata per il solo fatto di essere matematicamente corretto. Ma non ritorno, qui, su cose già discusse.

Sorvolo sulle questioni degli angioletti o del rendere meno sfumato il discorso così da renderlo comprensibile ai più o sullo sperare di dimenticare cose sentite a seminari poichè, anche se sono parole di una persona che si occupa di Scienza, con la scienza non hanno nulla a che fare. Mi astengo dal commentare.

Saluti

Patrizio

Una brevissima precisazione sull’ipotesi ‘pioggia=angeli che piangono’; che non voleva essere certo derisoria o irriverente (per questo scrivo ancora questa ultima risposta: per evitare che il tono di questo dibattito, finora incanalato su un binario ‘scientifico-divulgativo’, possa scadere a livello più basso). Al contrario, questo è uno dei classici esempi di ipotesi ‘ad hoc’, slegata da ogni teoria ‘organica’, che di per sè (se si postula che gli angioletti non siano visibili nè rilevabili in alcun modo) non può essere confutata nè dimostrata. Solo il rasoio di Occam, o tesi più recenti come la ‘verificabilità’ e ‘falsificabilità’ definite da Popper, possono eliminarla: perchè appunto presuppone ‘enti supplementari’ (gli angioletti) che compaiono solo in questo caso, piuttosto che spiegare il fenomeno in base ad una teoria ‘universale’ come il passaggio di fase dell’acqua. Non voglio tediare oltre i lettori, ma faccio notare come all’alba della civiltà umana si usasse appunto spiegare ogni fenomeno macroscopico (o gruppo ristretto di fenomeni) con un ‘Ente’ diverso (in genere una una divinità: Thor o Zeus per la generazione del tuono, Cerere per la crescita del grano, ecc.); poi, l’evoluzione del pensiero filosofico ha portato al metodo scientifico moderno, di cui il rasoio di Occam è stato tappa fondamentale.

Così, poichè le rocce sono comunque dei corpi solidi, la teoria della dislocazione elastica per esse certamente vale (e d’altra parte, già parlare di ‘faglia’ significa riconoscerlo), entro determinate approssimazioni. Introdurre altri ‘Enti’, per il rasoio di Occam, può essere consentito solo in presenza di evidenze ‘macroscopiche’ che non possono essere ragionevolmente spiegate da questa sola teoria. Evidenze che, a mio avviso, ad avviso di Segall ed Heimisson, e di tanti altri sismologi (moltissimi, quasi tutti) non ci sono. Stavolta ho davvero concluso questo dibattito, qualunque siano gli ulteriori interventi: perchè non credo di riuscire a spiegare più di così il mio pensiero sull’argomento.

Caro Gianluca, grazie per questa tua intervista che alimenta la discussione alla base della ricerca scientifica, importante sia tramite canali ufficiali (le riviste peer-reviewed) che, in qualche modo, su blog come questo. Condivido ciò che dice nel suo commento Giuseppe De Natale, che riprende un concetto di Popper, ovvero che la Scienza progredisce attraverso nuove proposte che spingono la comunità scientifica a chiarire meglio i concetti ed a trovare precisamente gli errori. Vedo con soddisfazione che l’argomento genera interesse e spero che in futuro il modello venga confutato o confermato da nuovi studi.

Il modello dei graviquakes, che tratto come autore o coautore in vari lavori, è spesso criticato sulla base del meccanismo di doppia coppia, che è un sistema di rappresentazione di forze non in contrasto con quanto previsto dal collasso gravitativo. Questo punto viene spesso sollevato e utilizzato come argomento a sfavore con “darebbe osservazioni diverse dal modello di doppia coppia”. Sarebbe interessante capire quali siano le differenze nelle osservazioni (sismologiche) di uno stesso risultato (scivolamento del tetto lungo la faglia) controllato però da due meccanismi differenti (accumulo di energia elastica o gravitazionale).

Non posso non notare, nel tuo post e nei commenti, una certa confusione tra la critica al modello generale e a uno dei suoi osservabili (o meglio al metodo utilizzato per evidenziarlo). Nell’articolo di Segall e Heimisson (2019), in effetti, si critica il metodo utilizzato per il calcolo del “volume unbalance” e si dimostra che per generare i valori di sollevamento/subsidenza descritti in Bignami et al. (2019) è sufficiente utilizzare una sorgente puntiforme (anche se con una discrepanza nei risultati del 20% che non è un valore trascurabile). Mi astengo dal commentare il metodo DinSAR poichè non conosco la materia. Il punto è che il risultato di Segall e Heimisson non confuta affatto il “volume unbalance” ma lo descrive a partire da un’ipotesi differente. Quanto discusso in quel lavoro si concentra su uno degli osservabili che il modello dei graviquakes cerca di giustificare teoricamente. Di conseguenza non vedo come il loro risultato possa perdipiù confutare (come confermi anche tu in un commento successivo) il modello generale. Il rasoio di Occam si applica quindi al volume unbalance, al metodo utilizzato per calcolarlo o al modello generale? Sono cose diverse.

Il mio commento non voleva però entrare nel merito del modello dei “graviquakes” (in quanto gia fatto da Carlo Doglioni nel post di risposta a questo tuo articolo). Piuttosto vorrei riportare, brevemente, alcune considerazioni che a me inducono a ragionare su un modello del ciclo sismico diverso (qualunque esso sia) e dubitare del convenzionale.

La teoria dell’elastic dislocation. Tu dici che, per descrivere il campo di deformazione generato da un forte terremoto questa teoria è comunemente accettata. Nel commento di De Natale leggo “La teoria della dislocazione elastica è estremamente generale, estremamente elegante e, in senso fisico-matematico, estremamente semplice. Le osservazioni fondamentali sono estremamente d’accordo con la teoria”. Quindi mi domando, la teoria della dislocazione elastica è il modello ultimo e abbiamo l’unico obiettivo di migliorarla e raffinarla? Approfondendo la letteratura al riguardo si hanno impressioni diverse. Ad esempio questa teoria è comunemente “utilizzata” (e non accettata) perchè, questo si, è “semplice”. La comunità dei ricercatori che si occupa di hazard sismico ne è consapevole, ed emerge chiaramente sia nei numerosi lavori che la criticano sia in quelli, altrettanto numerosi, che la utilizzano. Le osservazioni fondamentali non sono “estremamente” d’accordo con la teoria; tuttaltro. Questo si può leggere e approfondire in numerosi articoli scientifici (si vedano ad esempio Stein et al., 2012; Wyss, 2015; Geller et al., 2016). Gli osservabili non sono così in accordo con quanto previsto dal modello (rimando ancora alla risposta di Doglioni). Le difese appassionate di tale modello (elastico) non mancano anche se il suo utilizzo ha portato in passato a numerosi errori di previsione.

Ad ogni modo il mio commento a tutta la discussione è che, a prescindere se i gravimoti rappresentino o meno un nuovo paradigma, bisogna ammettere che nella letteratura si percepisce dell’incertezza sull’argomento, che porta a farsi domande e forse nasconde la necessità di una teoria alternativa. Ben venga il dibattito.

Bignami, C., Valerio, E., Carminati, E., Doglioni, C. and Tizzani, P. (2019). Volume unbalance on the 2016 Amatrice – Norcia (central Italy) seismic sequence and insights on normal fault earthquake mechanism. Scientific Reports, 9:4250.

Geller, R.J., Mulargia, F. and Stark., P.B. (2016). Why we need a new paradigm of earthquake occurrence. Subduction dynamics: From mantle flow to mega disasters, geophysical monograph 211, 183-191.

Segall P. and Heimisson, H.R. (2019). On the Integrated Surface Uplift for Dip-Slip Faults. Bulletin of the Seismological Society of America, 109 (6): 2738-2740.

Stein, S., Geller, R.J. and Liu, M. (2012). Why earthquake hazard maps often fail and what to do about it. Tectonophysics, 562, 1-25.

Wyss, M. (2015). Testing the basic assumption for probabilistic seismic‐hazard assessment: 11 failures. Seismological Research Letters, 86(5), 1405-1411.

Ho letto con attenzione i vari interventi, la questione mi sembra importante perché riguarda i fondamenti dell’avanzamento della conoscenza. Mi sento di riportare solo una breve considerazione che non ho visto rimarcata con il dovuto rilievo. La pubblicazione di Segall e Heimisson, 2019, una nota breve apparentemente marginale nel corpo della letteratura scientifica e con la pretesa di commentare una pubblicazione specifica sull’argomento “gravimoto” (Bignami et al., 2019), nasconde in realtà una vera e propria chicca scientifica, una piccola scoperta che lascia stupiti anche gli esperti del settore. Gli autori, Paul Segall un professore di geofisica all’Università di Stanford ed Elías Heimisson uno studente brillante appena dottorato, hanno ricavato una formula matematica semplice nella sua struttura ma che esprime una legge di conservazione fondamentale, sconosciuta finora ai libri di testo in sismologia. Nell’ambito della teoria della dislocazione elastica, la formula quantifica il disavanzo di volumi spostati della crosta terrestre in caso di terremoto, cioè la differenza tra il volume sollevato e quello abbassato. Esprime cioè la deformazione della superficie terrestre indotta dai terremoti nell’ipotesi che la crosta terrestre sia assimilabile ad un materiale comprimibile ed elastico. Tale deformazione è spazialmente simmetrica solo in casi molto particolari (faglie verticali) e dalla misura di tale asimmetria si possono ricavare informazioni sulla sorgente causale del terremoto. Questa deformazione risulta ora misurabile con tecniche satellitari (ad es. InSAR) e quindi la formula di Segall & Heimisson appare ancor più preziosa permettendo di mettere alla prova la teoria. Cosa prevede dunque la formula di Segall & Heimisson per il terremoto di Norcia 2016? Un semplice calcolo, assumendo valori medi dei parametri elastici per la crosta terrestre, rivela che il disavanzo di volumi è negativo e vale -0.08 km3. Il lavoro di Bignami et al., 2019 riporta un valore misurato con tecniche InSAR del disavanzo pari a -0.1 km3. La differenza tra teoria e misura è del 20%, uno scarto assai piccolo considerando che le ipotesi di partenza sono estremamente semplificate. Questo semplice risultato permette a Segall & Heimisson di suggerire la lex parsimoniae di Ockham per rigettare (per ora) le teorie alternative che si pongono in contrapposizione alla dislocazione elastica.

Caro Gianluca, sono perfettamente d’accordo con le tue argomentazioni, e sposo appieno le tesi di Segall e Heimisson. Ho letto anche la risposta di Carlo Doglioni, che è una difesa appassionata del modello proposto. E’ bello e giusto che un Ricercatore difenda ciò che crede corretto; è così che la Scienza progredisce: attraverso nuove proposte, per lo più errate, che spingono però la comunità scientifica a chiarire meglio i concetti ed a trovare precisamente gli errori. E’ chiaro che non è possibile in questa sede trattare rigorosamente di Sismologia, che è una disciplina complessa e richiede una trattazione matematica molto avanzata. Potrei certamente commentare alcuni concetti espressi da Doglioni: ad esempio, le sue affermazioni sul fatto che in profondità non esistano sforzi tensionali ‘assoluti’ non aggiungono nulla al problema, in quanto ciò che conta nel modello di terremoto a doppia coppia sono gli sforzi deviatorici. E certamente il meccanismo di ‘collasso gravitativo’, in termini di meccanismo focale, darebbe osservazioni sismiche significativamente diverse dal modello a doppia coppia. Ci sarebbe anche da discutere sul valore ‘assoluto’ dei dati positivi e negativi nelle immagini SAR; problema comunque superato in ogni caso dalle considerazioni contenute nel lavoro citato del BSSA. Ma il problema non è questo, che certamente non sarebbe affrontabile in questa sede. Il problema è quello in gran parte affrontato e chiarito appunto nel lavoro di Segall e Heimisson, e che tu hai giustamente richiamato in forma discorsiva/divulgativa. Nella sua forma più generale, esso è sintetizzato nelle frasi finali del lavoro citato, ma è molto più profondo: la Scienza è di per sè conservativa; quando si vuol proporre un nuovo modello per sostituire quello accreditato, è necessario prima di tutto che quello finora adottato sia chiaramente incapace di spiegare alcune osservazioni fondamentali; poi, che il nuovo spieghi perfettamente tutte le osservazioni pregresse, almeno come il vecchio modello, e in più spieghi le nuove. La teoria della dislocazione elastica è estremamente generale, estremamente elegante e, in senso fisico-matematico, estremamente semplice. Le osservazioni fondamentali sono estremamente d’accordo con la teoria, entro i limiti delle approssimazioni implicite in fenomeni così complessi. Le stesse immagini SAR, da quando esistono, forniscono osservazioni incredibilmente in accordo con la teoria, sviluppata in mezzi puramente elastici, quindi ‘ideali’, pur riferendosi a mezzi, come le rocce terrestri, molto più complessi ed ‘imperfetti’. E’ qui il nocciolo della questione: non ha molto senso contestare un modello fisico-matematico semplice, elegante, ed universalmente in grado di spiegare le osservazioni principali in base a piccole differenze nelle osservazioni, che (se anche ci fossero) dipendono essenzialmente dal fatto che la teoria si riferisce necessariamente a modelli ‘ideali’ elastici che possono solo approssimare il comportamento del mezzo reale. In gergo, si direbbe che si vuole ‘interpolare il noise’, ossia dar peso a dettagli che non riguardano il problema fisico bensì gli errori, di misura o di approssimazione del modello. Nel nostro caso, le osservazioni di dettaglio, dovute alla differenza tra il mezzo elastico ideale ed il mezzo ‘reale’, geologico, possono essere certamente localmente interessanti da analizzare, per i motivi più diversi: ma sono su un altro piano, non certo confrontabile con il modello fisico-matematico, universale, che spiega la sismicità di qualunque natura (perché non dimentichiamo che la teoria della dislocazione elastica non spiega soltanto la sismicità tettonica, a doppia coppia, ma quella dovuta ad ogni tipo di sorgente: comprese le esplosioni, che anzi, quelle nucleari, sono state la ragione principale del grande sviluppo della Sismologia tra gli anni ’60 ed ‘80). Tutto questo, Segall ed Heimisson l’hanno sintetizzato nella frase relativa al ‘Rasoio di Occam’ (dal nome del frate francescano che, già nel 1300, espresse uno dei più importanti principi che ancora oggi guidano la Scienza; e che consente di distinguere le vere ‘scoperte’ da semplici ipotesi ridondanti e non necessarie). In conclusione, credo sia proprio la mancanza di reali implicazioni fondamentali del modello ‘graviquakes’ (termine anch’esso a mio avviso improprio, perché earthquake significa ‘moto della terra’, che è indipendente da come sia generato), significativamente diverse dal modello acclarato di dislocazione elastica, che a mio avviso ha fatto sì che finora, e con la sola eccezione di Segall e Heimisson, la comunità scientifica se ne sia di fatto disinteressata; anche nell’eventuale critica.

Ciao Gianluca,

condivido anche io sulla grande utilità delle immagini INSAR, che hanno portato nuovi dati nel confronto scientifico.

grazie a te della risposta.

“che i volumi crostali mobilitati da un forte terremoto non devono necessariamente azzerarsi tra sollevamento e subsidenza” è un dato di fatto sopratutto per chi osserva le faglie in affioramento. Osservando le faglie in affioramento si nota come i volumi non si sono azzerati e mai si azzereranno. Se il “volume unbalance” si verifica anche per il terremoto accaduto in Emilia, definito come elastomoto, che nel tempo dovrebbe andare verso un bilanciamento secondo la teoria del “rimbalzo elastico”, allora mi chiedo se questo modello fisico rispecchia le condizioni reali che si osservano in natura. Il modello dei “gravimoti” legato al processo della dilatanza con la formazione di microfratture, trova grande riscontro in affioramento dove è possibile identificare queste strutture (fratture, vene riempite di calcite, presenza di fluidi).

Queste strutture non vengono prese in considerazione dal modello del rimbalzo elastico, rappresentano la differenza sostanziale tra i due modelli. Personalmente continuo a sostenere l’idea che un modello fisico o matematico debba trovare riscontro in natura per potere spiegare in modo più reale il fenomeno studiato. Ritengo che quanto descritto da Bignami et al. (2019) rappresenti un forte punto di partenza nello studio dei terremoti che guardano maggiormente al contesto naturale in cui si generano.

Caro Paolo,

sul fatto che un modello fisico o matematico debba trovare riscontro in natura io non ho il benché minimo dubbio. Infatti è proprio questo il punto centrale della questione. Io non ho nulla contro i graviquakes, e mi considero abbastanza ignorante da non poter e voler entrare in un contraddittorio di natura teorica sulla loro esistenza. Ho però una infarinatura sulla modellazione di grandi terremoti attraverso la elastic dislocation theory. Io stesso molti anni fa ho scritto codici di inversione del campo di deformazione crostale – misurato con la geodesia classica, perché il SAR doveva ancora affermarsi – per stimare la geometria e l’entità della dislocazione non di sorgenti puntiformi, ma di faglie modellate come composte da microsorgenti che potevano descrivere anche piani curvi o listrici. Quindi conosco abbastanza i termini del problema.

Quello che contesto, e meglio di me lo hanno fatto Segall e Heimisson, è l’esistenza del volume unbalance, che io considero in larga misura un artefatto della particolare tecnica usata per misurare i volumi stessi. Se avessi ragione io, per me questo significherebbe solo che quanto pubblicato da Bignami et al. NON è una dimostrazione dell’esistenza dei graviquakes: ma questo non implica che i graviquakes non possano esistere ugualmente.

Permettimi poi un commento sulla tua affermazione “Osservando le faglie in affioramento si nota come i volumi non si sono azzerati e mai si azzereranno”. Francamente non capisco proprio come una affermazione di questo genere possa essere sostanziata solo “osservando” le faglie, e per di più osservandole solo in affioramento, il che implica perdere del tutto il controllo sulla terza dimensione, ovvero su quello che avviene sotto i nostri piedi e fino alla base della crosta fragile. Il SAR è uno strumento straordinario – e sarà sempre più utilizzato in futuro – proprio perché consente al geologo di esplorare processi che hanno luogo a profondità alle quali il geologo non potrà mai arrivare di persona.

Quello che scrivi mi ricorda alcuni colleghi geologi che tanti anni fa erano convinti del fatto che le grandi faglie normali dell’Appennino fossero caratterizzare solo da footwall uplift, senza che a questo fosse associata anche della subsidenza. Questo meccanismo veniva invocato – ma parliamo veramente di due decenni fa – per spiegare la surrezione della catena appenninica, generata da faglie normali che sollevano montagne per migliaia di metri ma non abbassano nulla: un Basin-and-Range con tanto range ma senza basin. Come dimostrano proprio le immagini DInSAR di qualunque forte terremoto generato da una faglia normale, non è questo quello che succede in natura: e la virtuale assenza di un bacino allungato di fronte ad alcune delle grandi faglie normali che ben conosciamo, come ad esempio quella del Monte Vettore, è un fatto che prima o poi andrà spiegato da chi sostiene che quelle faglie sono le attrici principali della tettonica in atto. Ma questo è un altro tema, che tratteremo in un’altra occasione.

Grazie comunque per il commento.