Gianluca Valensise, sismologo di formazione geologica, dirigente di ricerca dell’INGV, è autore di numerosi studi sulle faglie attive in Italia e in altri paesi. In particolare è il “fondatore” della banca dati delle sorgenti sismogenetiche italiane (DISS, Database of Individual Seismogenic Sources: https://diss.ingv.it). Gli abbiamo chiesto di commentare l’ultima versione, pubblicata di recente.

Gianluca, puoi spiegare ai non addetti ai lavori in che cosa consiste questo database?

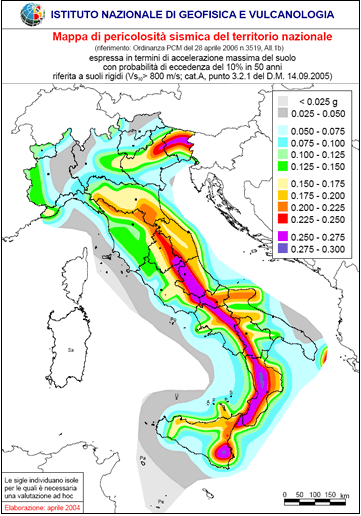

Il Database of Individual Seismogenic Sources, o DISS, è uno strumento ideato per censire le sorgenti sismogenetiche, ovvero le faglie in grado di generare forti terremoti che esistono su uno specifico territorio, esplorandone le dimensioni, la geometria e il comportamento atteso, espresso dallo slip rate e dalla magnitudo degli eventi più forti che tali faglie possono generare. Presenta delle somiglianze con un catalogo/database della sismicità storica, nella misura in cui fornisce informazione georeferenziata sul verificarsi dei forti terremoti, potendo fungere da base di partenza per l’elaborazione di modelli di pericolosità sismica a varie scale spaziali e temporali; tuttavia se ne differenzia per due ragioni fondamentali. La prima è quella di essere principalmente basato su informazione geologica, geofisica e sismometrica, e in parte anche storica. La seconda, che ne rappresenta la vera forza, e quella di “guardare in avanti” in modo esplicito, proponendo dove potrebbero accadere i terremoti del futuro e con quali caratteristiche. Anche un catalogo storico può essere utilizzato con le stesse finalità, sulla base del principio-cardine della Geologia per cui è possibile “ribaltare sul futuro” gli eventi naturali che abbiamo visto nel passato; ma l’immagine del futuro che potrà derivare da quest’operazione è certamente meno nitida di quella che si può ottenere ipotizzando l’attivazione futura di sorgenti sismogenetiche delle quali, almeno nell’ambito di incertezze anche ampie, riteniamo di conoscere le caratteristiche fondamentali, come lunghezza, profondità, cinematica e magnitudo del terremoto più forte che possono generare. Continua a leggere